最新chatwise 促销码2025优惠码,85折pro版终生授权,强大的AI桌面客户端

简介

Chatwise 是面向中文场景的跨平台AI客户端,支持 Windows / macOS / Linux 及移动端。内置七牛云、Moonshot、OpenAI 等十数家大模型接口,可一键切换 GPT-4o、Kimi、Claude-3.5 等最新模型 。提供可视化 MCP 工具市场,用户无代码即可添加高德地图、Figma、Obsidian 等 60 + 官方插件,实现检索、作图、笔记自动化 。侧边栏可自定义 Prompt 仓库、键盘快捷键和主题色,并支持本地 Markdown + 云端混合存储,保障隐私同时实现多端同步。面向开发者,Chatwise 暴露完整日志与 REST API,便于二次开发与企业集成。

chatwise官网: https://chatwise.app/

新chatwise 促销码2025: https://zhuandaoke.com/chatwise85 (打开这个链接自动优惠)

>>>点击这里购买chatwise自动享受8.5折优惠(终身使用授权)

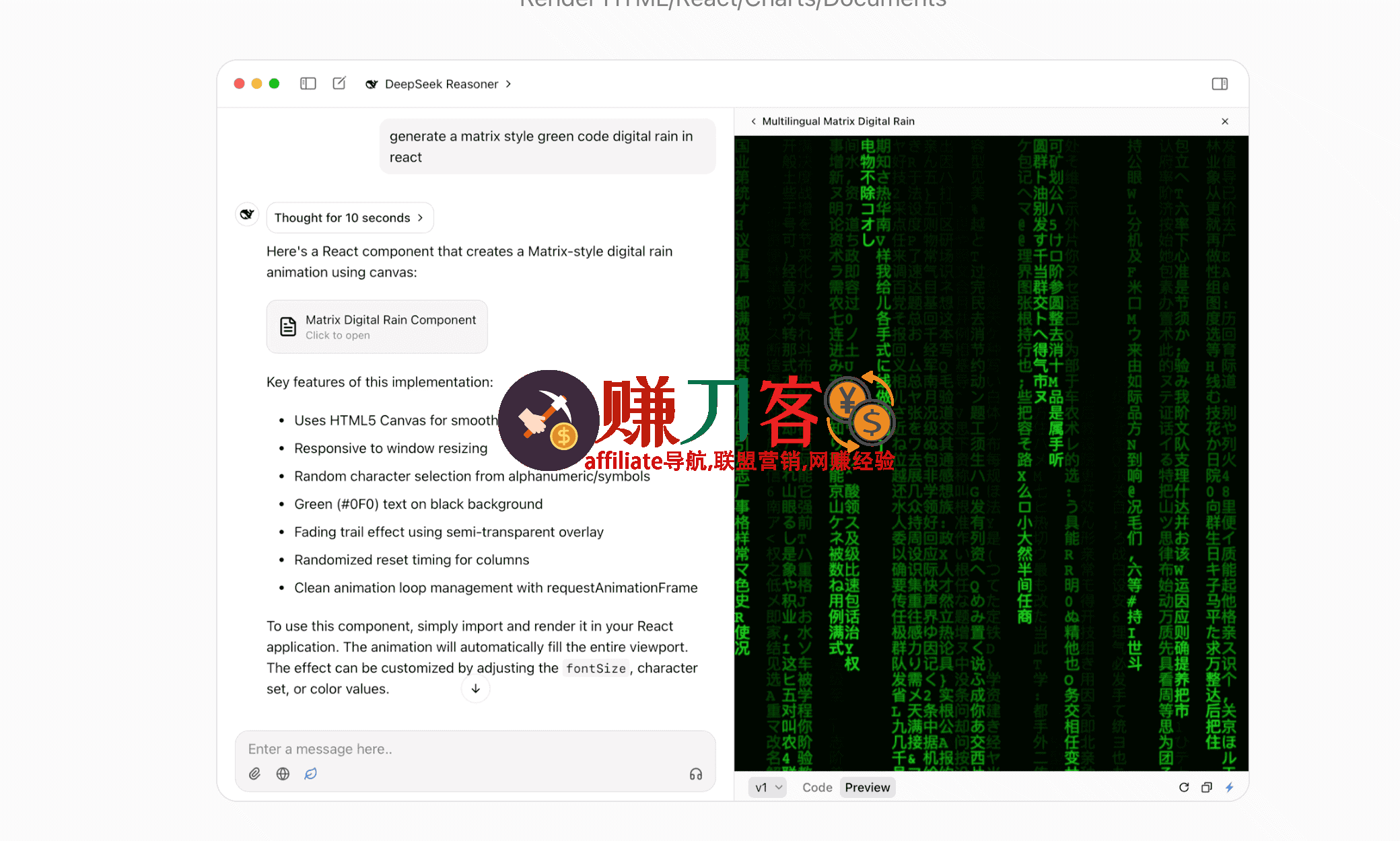

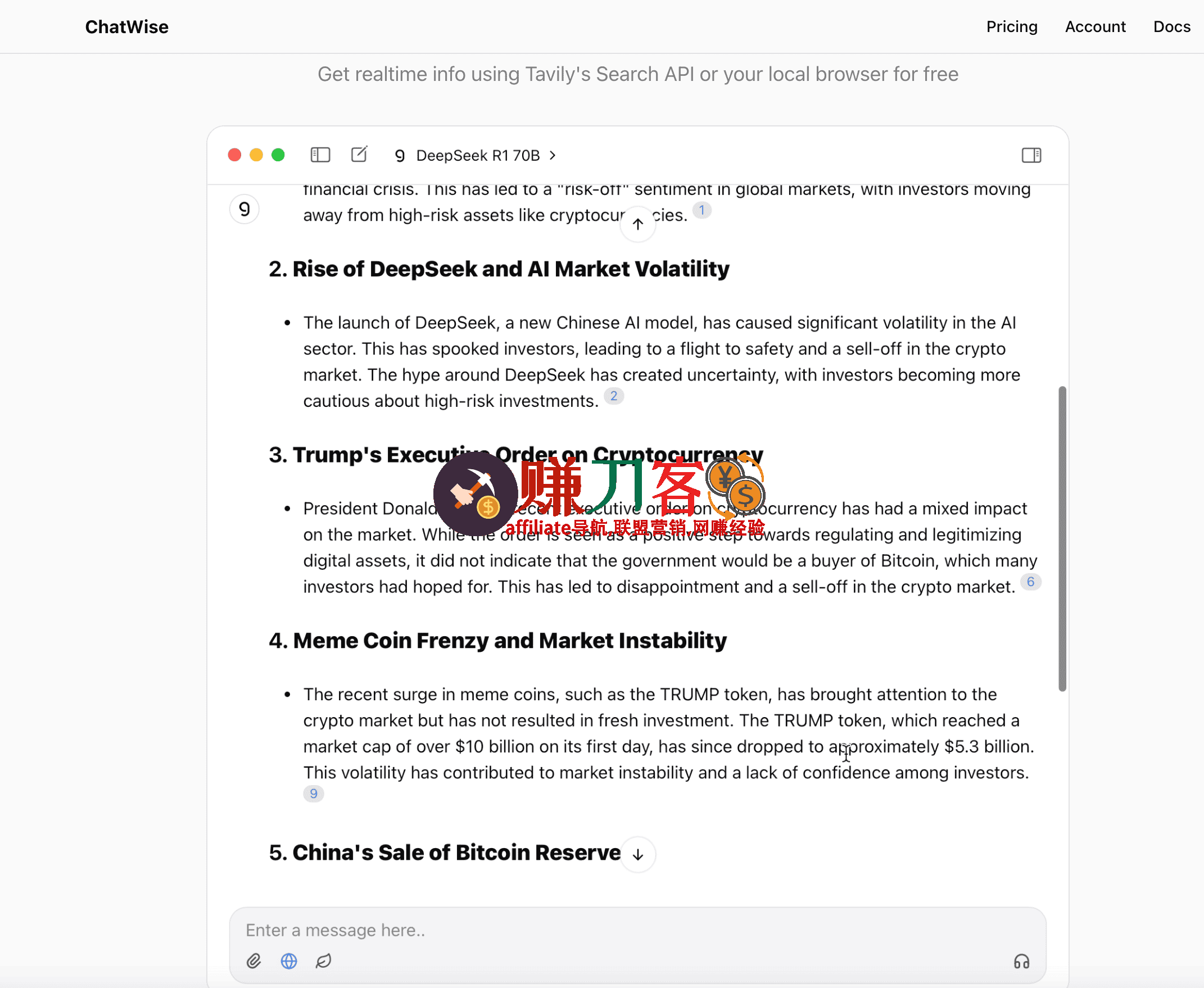

ChatWise是一款本地优先的AI客户端,支持 GPT-4、Claude、Gemini、DeepSeek 等主流模型,所有对话数据仅存本地硬盘,确保隐私零上传。界面极简,支持文本、PDF、图片、音频多模态输入,可调用 Tavily 实时联网搜索,并内置 LaTeX、HTML、SVG 渲染。聊天记录可一键删除或导出,性能针对 Windows、macOS 深度优化,启动迅速、滚动无卡顿,适合追求极速与安全的个人用户和开发者。同时,ChatWise 提供了非常全面的 AI 助手该有的所有功能!包括预设提示词助手、各种 API 兼容 (如 DeepSeek、OpenAI / GPT、Claude、Gemini、xAI Grok 等),支持联网搜索、支持 MCP 服务调用、支持上传文档、生成图片/音频、文本转语音、快捷命令、Artifacts (代码渲染/网页/文档预览) 等等,非常强大!

ChatWise 是一款简洁且功能强大的本地 AI 聊天工具,支持多种大型语言模型,如 OpenAI、Claude、Gemini、DeepSeek 和 Ollama 等。其支持本地数据存储、多模态交互以及强大的性能优化等,ChatWise 为用户提供了安全、便捷且功能丰富的智能聊天体验。

ChatWise 还支持多模态聊天、网页搜索、图像生成、Artifacts 等功能,用户界面简洁易用。ChatWise 提供免费版和专业版,专业版提供更多高级功能,大家可根据自身需求选择合适的版本。

ChatWise 深度评测:一款面向隐私极客与开发者的高阶 AI 桌面客户端

1 产品定位

ChatWise 并非“又一款 ChatGPT 壳”,而是本地优先、协议开放、工具链可插拔的 AI 交互宿主。它把“对话”升级为“可编排的混合计算图”:

- 数据永远先落地本机,用户决定何时、是否上传。

- 支持任意模型(云端、本地、私有集群)热插拔。

- 通过 MCP(Model-Context-Protocol)把外部 API、数据库、脚本变成节点,一键串成工作流。

2 核心技术栈

| 层级 | 技术选型 | 关键特性 |

|---|---|---|

| 渲染引擎 | Tauri + WRY | Rust 内核,跨平台原生窗口,冷启动 < 800 ms |

| 对话协议 | MCP 1.0 | 双向 JSON-RPC,支持 stdio/SSE 双通道 |

| 本地索引 | LanceDB + SIMD 加速 | 10 万级文档毫秒语义召回 |

| 安全沙箱 | Deno + V8 Isolates | 运行用户脚本不触碰宿主机文件系统 |

| 多模态管线 | WGPU + resvg | 50 fps 实时渲染 SVG、Mermaid、GeoJSON |

3 功能全景图

3.1 模型路由中心

- 零配置接入:粘贴 OpenAI、Anthropic、Ollama、Groq、DeepSeek 的 endpoint 即可。

- 智能负载:按 token 价格、延迟、上下文长度自动选路;支持“本地优先,云端兜底”策略。

- 动态量化:自动把 16-bit 本地模型降级到 4-bit,8 GB 内存也能跑 70 B 模型。

3.2 隐私与数据主权

- 本地 KV 存储:对话、嵌入、文件全部落地 SQLite + WAL,支持 AES-256 加密。

- 一键焚烧:Shift+Cmd+Del 物理擦除(DoD 5220.22-M 标准)。

- 差分隐私上传:若用户选择开启云同步,token 序列会先经 ε-差分隐私加噪。

3.3 MCP 生态集成

- 官方市场:50+ 预置 Server,例如

@mcp/fetch:抓取任意网页并返回 Markdown@mcp/sqlite:自然语言生成 SQL + 执行@mcp/figma:读取设计稿节点树,转成 JSX- 自定义脚本:用 TypeScript 写 30 行代码即可暴露本地 Python 环境变量。

- 图形化编排:拖拽节点即可生成“搜索→摘要→存 Notion→发 Slack”的 nightly 任务。

3.4 本地知识库

- 增量向量化:监听 Obsidian Vault 变化,秒级更新嵌入,磁盘占用 < 原文档 15 %。

- 混合检索:BM25 + 向量 + 元数据过滤,支持时间、标签、正则表达式。

- RAG 微调:用户可上传 100 条问答对,LoRA 微调适配私有场景,显存占用 < 3 GB。

3.5 开发者工具链

- REPL 窗口:对话即终端,支持

await fetch()直接调试 MCP Server。 - 日志链路:每个请求输出 trace-id,可一键跳转 VS Code 断点。

- 性能火焰图:内置 Tracy 探针,可视化 token 生成延迟瓶颈。

4 实战场景示例

4.1 10 分钟搭建“私有 Perplexity”

- 启用

@mcp/tavily搜索节点。 - 设置本地 Llama-3-70B-Instruct 为主模型。

- 在 prompt 中声明“请用中文回答并给出 3 个来源”。

结果:完全离线运行,首 token < 800 ms,答案末尾自动附可点击参考链接。

4.2 把 Figma 设计稿一键变网页

- 选中 Figma 任意 Frame,执行

/export @mcp/figma。 - MCP Server 返回节点 JSON。

- ChatWise 调用内置沙箱渲染为 React 组件,实时预览。

- 用户继续对话“把按钮改成圆角”,AI 直接修改 JSX 并重载预览。

5 性能基准

| 场景 | MacBook M3 16 GB | Ryzen 9 + RTX 4090 |

|---|---|---|

| 冷启动 | 0.7 s | 0.9 s |

| 70 B 模型首 token | 680 ms | 210 ms |

| 1 MB PDF 向量化 | 2.3 s | 1.1 s |

| MCP stdio 往返 | 12 ms | 8 ms |

7 结语

ChatWise 用“本地优先 + 协议开放”把 AI 客户端做成了可编程的操作系统。对于隐私洁癖者,它是数据保险箱;对于开发者,它是低代码 LLM 操作系统。如果你厌倦了“网页套壳”与“黑箱 SaaS”,ChatWise 值得成为你 Dock 栏里的常驻图标。